Resumen de la Tesis Doctoral del Becario 2014

2022/5/10

Mi nombre es Daniel Góngora. Soy ingeniero electrónico por la Universidad Mayor de San Andrés. Gracias a la beca del gobierno de Japón, estudié en la Universidad de Tohoku entre Octubre de 2014 y Septiembre de 2019, de dónde me gradué como doctor en ciencias de la información. Desde Octubre de 2019 me desempeño como ingeniero en el Centro de Tecnología Avanzada de Nissan en Japón.

Durante mis estudios en la Universidad de Tohoku, mi investigación se desarrolló en el campo de la tecnología háptica bajo la supervisión del Prof. Masashi Konyo. La tecnología háptica se ocupa, entre otras cosas, de representar la información en forma de estímulos para el sentido del tacto. Un ejemplo de tecnología háptica son las vibraciones de un dispositivo móvil en respuesta a una llamada o a un nuevo mensaje. Aunque las vibraciones de un dispositivo móvil son un buen ejemplo por su ubicuidad, el potencial de las vibraciones cutáneas va más allá de su aplicación como notificaciones. Por ejemplo, las vibraciones cutáneas han demostrado gran potencial como apoyo en tareas remotas [1] y como parte de sistemas de entretenimiento [2].

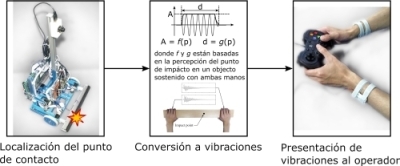

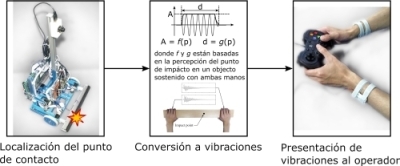

Mi investigación se enfocó en aplicar vibraciones cutáneas para mejorar la experiencia de movimiento en videos tomados en primera persona. La primera contribución de mi investigación fue un método basado en vibraciones cutáneas para mejorar la conciencia espacial durante la operación remota de robots móviles, ver Fig. 1. Durante la operación remota de robots móviles, el operador utiliza el vídeo transmitido por el robot para completar la misión. Cuando una colisión ocurre con un objeto fuera del campo visual del robot, el operador utiliza señales visuales producidas por el movimiento de la cámara para detectar la colisión. Sin embargo, las señales visuales producidas por una colisión no son confiables pues su intensidad depende de múltiples factores como ser el punto de contacto, la configuración del robot, la velocidad del robot, etc. Métodos para facilitar la detección y respuesta a una colisión son necesarios porque retrasos en la respuesta incrementan el riesgo de que el robot quede atascado y que la misión fracase. El método descrito en [3] consiste en representar el punto de contacto durante una colisión frontal mediante las diferencias en amplitud y duración de vibraciones presentadas en las manos. Esta representación del punto de contacto está inspirada en las características de las vibraciones de impacto que una persona extrae para localizar el punto de impacto en un objeto sostenido con ambas manos. En una evaluación preliminar, las vibraciones generadas por este método ayudaron a los operadores de un robot móvil a responder a una colisión frontal en menor tiempo.

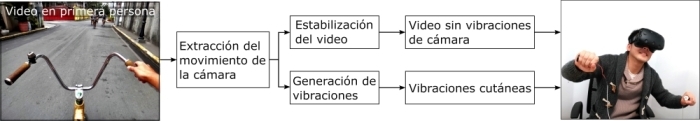

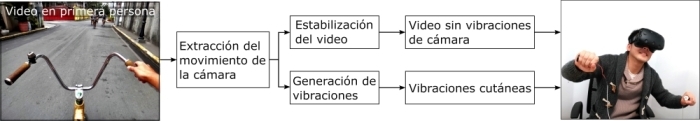

Otra contribución de mi investigación fue un método basado en vibraciones cutáneas para mejorar la calidad de experiencia al mirar videos en primera persona, ver Fig. 2. En concreto, mi investigación se enfocó en videos caracterizados por intensas vibraciones de la cámara que producen una pobre experiencia visual. La forma tradicional para mejorar la experiencia visual de este tipo de videos consiste en remover las vibraciones mediante técnicas de estabilización de videos. Sin embargo, al remover las vibraciones del video se pierde también el dinamismo de la actividad representada en el mismo. Como solución a este problema, en [4] presentamos un método para generar automáticamente vibraciones cutáneas para ambas manos basadas en el movimiento de la cámara. En [5] demostramos que la canalización del movimiento intenso mediante vibraciones cutáneas produce una experiencia visual más confortable en relación a videos sin vibraciones cutáneas o con vibraciones generadas aleatoriamente.

Durante mis estudios en la Universidad de Tohoku, y gracias al apoyo del Prof. Konyo, también tuve la oportunidad de investigar otros tipos de tecnología háptica. Por ejemplo, investigué ilusiones de movimiento basadas en estímulos termales [6] como parte de una colaboración nacida de una pasantía en la universidad de KEIO. Asimismo, como parte de concursos de innovación, participé en la concepción e implementación de nuevas experiencias basadas en tecnología háptica que incluyen un dispositivo móvil con pantalla de fricción variable (https://youtu.be/RPXFvNnCIIY), un respaldo para sillas equipado con múltiples actuadores táctiles (https://youtu.be/q2U_IZ0wkWk), y un dispositivo de estimulación ultrasónica (https://youtu.be/MmQQdLKHn-w).

En resumen, la beca del gobierno de Japón me permitió dar mis primeros pasos como investigador y me proporcionó oportunidades profesionales difíciles de alcanzar de otro modo.

Referencias

[1] Kontarinis, D. A., & Howe, R. D. (1995). Tactile display of vibratory information in teleoperation and virtual environments. Presence: Teleoperators & Virtual Environments, 4(4), 387-402.

[2] Seo, J., Mun, S., Lee, J., & Choi, S. (2018, April). Substituting motion effects with vibrotactile effects for 4D experiences. In Proceedings of the 2018 CHI Conference on Human Factors in Computing Systems (pp. 1-6).

[3] Gongora, D., Nagano, H., Suzuki, Y., Konyo, M., & Tadokoro, S. (2017, May). Collision representation using vibrotactile cues to bimanual impact localization for mobile robot operations. In 2017 IEEE International Conference on Robotics and Automation (ICRA) (pp. 461-468). IEEE.

[4] Gongora, D., Nagano, H., Konyo, M., & Tadokoro, S. (2017, June). Vibrotactile rendering of camera motion for bimanual experience of first-person view videos. In 2017 IEEE World Haptics Conference (WHC) (pp. 454-459). IEEE.

[5] Gongora, D., Nagano, H., Konyo, M., & Tadokoro, S. (2018, November). Exciting but comfortable: Applying haptic feedback to stabilized action-cam videos. In International AsiaHaptics conference (pp. 287-293). Springer, Singapore.

[6] Gongora, D., Peiris, R. L., & Minamizawa, K. (2017, October). Towards Intermanual Apparent Motion of Thermal Pulses. In Adjunct Publication of the 30th Annual ACM Symposium on User Interface Software and Technology (pp. 143-145).

Fig. 1. Ilustración del proceso de generación de vibraciones cutáneas para mejorar la conciencia espacial durante la operación remota de robots móviles.

Fig. 2. Ilustración del proceso de generación de vibraciones cutáneas para mejorar la experiencia de videos en primera persona

Durante mis estudios en la Universidad de Tohoku, mi investigación se desarrolló en el campo de la tecnología háptica bajo la supervisión del Prof. Masashi Konyo. La tecnología háptica se ocupa, entre otras cosas, de representar la información en forma de estímulos para el sentido del tacto. Un ejemplo de tecnología háptica son las vibraciones de un dispositivo móvil en respuesta a una llamada o a un nuevo mensaje. Aunque las vibraciones de un dispositivo móvil son un buen ejemplo por su ubicuidad, el potencial de las vibraciones cutáneas va más allá de su aplicación como notificaciones. Por ejemplo, las vibraciones cutáneas han demostrado gran potencial como apoyo en tareas remotas [1] y como parte de sistemas de entretenimiento [2].

Mi investigación se enfocó en aplicar vibraciones cutáneas para mejorar la experiencia de movimiento en videos tomados en primera persona. La primera contribución de mi investigación fue un método basado en vibraciones cutáneas para mejorar la conciencia espacial durante la operación remota de robots móviles, ver Fig. 1. Durante la operación remota de robots móviles, el operador utiliza el vídeo transmitido por el robot para completar la misión. Cuando una colisión ocurre con un objeto fuera del campo visual del robot, el operador utiliza señales visuales producidas por el movimiento de la cámara para detectar la colisión. Sin embargo, las señales visuales producidas por una colisión no son confiables pues su intensidad depende de múltiples factores como ser el punto de contacto, la configuración del robot, la velocidad del robot, etc. Métodos para facilitar la detección y respuesta a una colisión son necesarios porque retrasos en la respuesta incrementan el riesgo de que el robot quede atascado y que la misión fracase. El método descrito en [3] consiste en representar el punto de contacto durante una colisión frontal mediante las diferencias en amplitud y duración de vibraciones presentadas en las manos. Esta representación del punto de contacto está inspirada en las características de las vibraciones de impacto que una persona extrae para localizar el punto de impacto en un objeto sostenido con ambas manos. En una evaluación preliminar, las vibraciones generadas por este método ayudaron a los operadores de un robot móvil a responder a una colisión frontal en menor tiempo.

Otra contribución de mi investigación fue un método basado en vibraciones cutáneas para mejorar la calidad de experiencia al mirar videos en primera persona, ver Fig. 2. En concreto, mi investigación se enfocó en videos caracterizados por intensas vibraciones de la cámara que producen una pobre experiencia visual. La forma tradicional para mejorar la experiencia visual de este tipo de videos consiste en remover las vibraciones mediante técnicas de estabilización de videos. Sin embargo, al remover las vibraciones del video se pierde también el dinamismo de la actividad representada en el mismo. Como solución a este problema, en [4] presentamos un método para generar automáticamente vibraciones cutáneas para ambas manos basadas en el movimiento de la cámara. En [5] demostramos que la canalización del movimiento intenso mediante vibraciones cutáneas produce una experiencia visual más confortable en relación a videos sin vibraciones cutáneas o con vibraciones generadas aleatoriamente.

Durante mis estudios en la Universidad de Tohoku, y gracias al apoyo del Prof. Konyo, también tuve la oportunidad de investigar otros tipos de tecnología háptica. Por ejemplo, investigué ilusiones de movimiento basadas en estímulos termales [6] como parte de una colaboración nacida de una pasantía en la universidad de KEIO. Asimismo, como parte de concursos de innovación, participé en la concepción e implementación de nuevas experiencias basadas en tecnología háptica que incluyen un dispositivo móvil con pantalla de fricción variable (https://youtu.be/RPXFvNnCIIY), un respaldo para sillas equipado con múltiples actuadores táctiles (https://youtu.be/q2U_IZ0wkWk), y un dispositivo de estimulación ultrasónica (https://youtu.be/MmQQdLKHn-w).

En resumen, la beca del gobierno de Japón me permitió dar mis primeros pasos como investigador y me proporcionó oportunidades profesionales difíciles de alcanzar de otro modo.

Referencias

[1] Kontarinis, D. A., & Howe, R. D. (1995). Tactile display of vibratory information in teleoperation and virtual environments. Presence: Teleoperators & Virtual Environments, 4(4), 387-402.

[2] Seo, J., Mun, S., Lee, J., & Choi, S. (2018, April). Substituting motion effects with vibrotactile effects for 4D experiences. In Proceedings of the 2018 CHI Conference on Human Factors in Computing Systems (pp. 1-6).

[3] Gongora, D., Nagano, H., Suzuki, Y., Konyo, M., & Tadokoro, S. (2017, May). Collision representation using vibrotactile cues to bimanual impact localization for mobile robot operations. In 2017 IEEE International Conference on Robotics and Automation (ICRA) (pp. 461-468). IEEE.

[4] Gongora, D., Nagano, H., Konyo, M., & Tadokoro, S. (2017, June). Vibrotactile rendering of camera motion for bimanual experience of first-person view videos. In 2017 IEEE World Haptics Conference (WHC) (pp. 454-459). IEEE.

[5] Gongora, D., Nagano, H., Konyo, M., & Tadokoro, S. (2018, November). Exciting but comfortable: Applying haptic feedback to stabilized action-cam videos. In International AsiaHaptics conference (pp. 287-293). Springer, Singapore.

[6] Gongora, D., Peiris, R. L., & Minamizawa, K. (2017, October). Towards Intermanual Apparent Motion of Thermal Pulses. In Adjunct Publication of the 30th Annual ACM Symposium on User Interface Software and Technology (pp. 143-145).

Fig. 1. Ilustración del proceso de generación de vibraciones cutáneas para mejorar la conciencia espacial durante la operación remota de robots móviles.

Fig. 2. Ilustración del proceso de generación de vibraciones cutáneas para mejorar la experiencia de videos en primera persona